Zdjęcie wygenerowane przez AI, pokazujące postrzelenie pielęgniarza z Minnesoty, zawiera nieprawdziwe elementy

- Opublikowano 11/02/2026, 14:55

- Przeczytasz w ciągu 3 minut

- Autor: Gwen Roley, AFP USA

- Tłumaczenie: Natalia SAWKA, AFP Poland

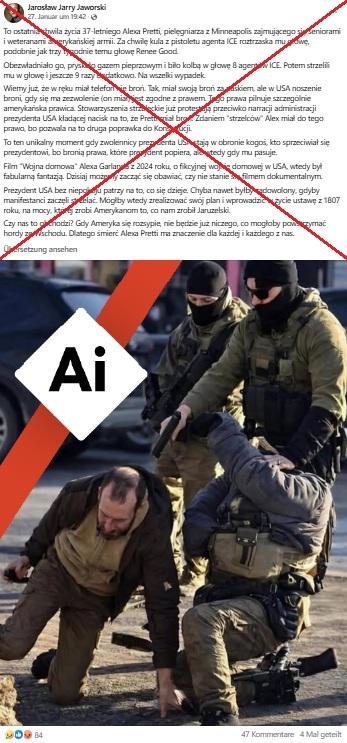

Media społecznościowe są pełne drastycznych materiałów filmowych z momentu, w którym federalni agenci imigracyjni zastrzelili 37-letniego pielęgniarza oddziału intensywnej terapii Alexa Prettiego w Minneapolis w stanie Minnesota. Jednak jedno z domniemanych ujęć z miejsca zdarzenia zostało zmanipulowane przy użyciu sztucznej inteligencji. Eksperci potwierdzili, że obraz był syntetycznym ulepszeniem autentycznego nagrania z miejsca strzelaniny, o czym świadczy fakt, że jednej z postaci brakuje głowy.

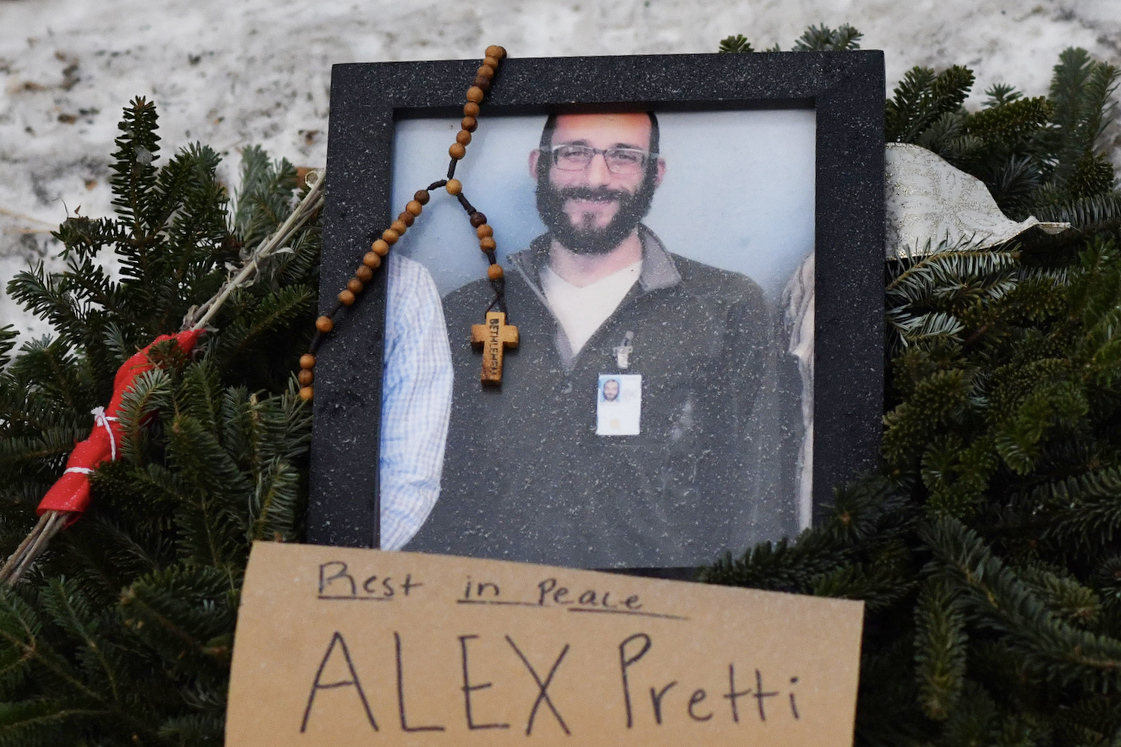

"Mężczyzna został zamordowany za to, że stanął w obronie zaatakowanej kobiety. Każdy z nas powinien tak postąpić. Mężczyzna nazywał się Alex Pretti" - czytamy we wpisie wraz ze zdjęciem na Facebooku z 27 stycznia 2026 roku.

Na zdjęciu agenci otaczają mężczyznę, prawdopodobnie Prettiego, który klęczy na ziemi, i celują mu w głowę z broni.

Użytkownicy zaczęli szybko rozpowszechniać zdjęcie na Facebooku i portalu X, zwracając uwagę na jego doskonałą jakość w porównaniu z innymi rozmazanymi nagraniami z tego zdarzenia, które udostępniano wcześniej. Użytkownicy wykorzystali to zdjęcie, aby skrytykować użycie siły przez amerykańskich agentów. "Alex Pretti był zwykłym przechodniem, który spokojnie stał na ulicy i został zamordowany przez faszystowską milicję, ponieważ stanął w obronie kobiety" – napisał jeden z nich na portalu X.

Publikacja była udostępniana również w innych językach, m.in. w języku angielskim i niemieckim.

Ostrzeżenie o treściach wrażliwych

Napięcia w Minneapolis związane z decycją prezydenta USA Donalda Trumpa o skierowaniu do miasta dodatkowych funkcjonariuszy służb imigracyjnych ponownie nasiliły się 24 stycznia. Tego dnia agenci federalni zastrzelili Alexa Prettiego, obywatela USA, po tym, jak obezwładnili go i powalili na ziemię.

Departament Bezpieczeństwa Krajowego twierdził, że pielęgniarz zamierzał funkcjonariuszy skrzywdzić. Jednak nagranie, które zostało zweryfikowane przez Bellingcat oraz dziennikarzy "The New York Times" pokazuje, że Pretti nie wyciągnął pistoletu, na który według lokalnych władz miał pozwolenie, a w chwili gdy został postrzelony, najwyraźniej był już rozbrojony (zarchiwizowane tutaj i tutaj).

Do incydentu doszło po strzelaninie z 7 stycznia, w której inna mieszkanka Minneapolis i obywatelka USA, Renee Good, została zastrzelona przez agenta ICE (ang. Immigration and Customs Enforcement). Administracja Trumpa w tym przypadku również twierdziła, że Good zagrażała życiu funkcjonariuszy, choć przeczą temu nagrania. Agencja AFP zdementowała kilka wprowadzających w błąd materiałów wizualnych rzekomo powiązanych z tym zdarzeniem i ofiarą.

Podobnie, rzekome zdjęcie w wysokiej rozdzielczości przedstawiające agentów strzelających do Prettiego zostało zmodyfikowane przy użyciu sztucznej inteligencji.

Wyszukiwanie obrazem pokazuje, że fotografia bardzo przypomina klatkę z jednego nagrania, co zostało potwierdzone przez "The New York Times", Bellingcat oraz inne źródła. Jednak autentyczne wideo jest znacznie bardziej rozpikselowane i ma gorszą jakość.

Kilka elementów rzekomo wysokiej jakości zdjęcia ma charakterystyczne cechy obrazów generowanych przez sztuczną inteligencję.

Agent klęczący obok postaci, która ma przedstawiać Prettiego, wydaje się nie mieć głowy. Jedna z nóg funkcjonariusza jest zgięta pod nienaturalnym kątem obok niezidentyfikowanego obiektu.

Przedmiot widoczny w prawej dłoni Prettiego na zmodyfikowanym zdjęciu, który niektórzy uznali za broń, pozostaje rozmazany. Autentyczne nagranie pokazuje jednak, że w tej ręce trzymał telefon.

Ostrzeżenie o treściach wrażliwych

Hany Farid, profesor Szkoły Informacji Uniwersytetu Kalifornijskiego w Berkeley, powiedział AFP, że laboratorium GetReal Security, które współzakładał, uznało, że obraz ten jest ulepszoną przez sztuczną inteligencję klatką z prawdziwego filmu. Powiedział, że tego typu generowanie obrazów przez sztuczną inteligencję stało się popularne, ponieważ użytkownicy próbują tworzyć wyraźne obrazy na podstawie oryginalnych filmów o niskiej jakości.

"Problem z tymi obrazami polega na tym, że ulepszenia wprowadzone przez sztuczną inteligencję powodują halucynacje szczegółów (podaje informacje, które nie mają pokrycia w faktach, przyp.red.)" – napisał w e-mailu z 26 stycznia.

Farid zwrócił uwagę na podobne posty, które syntetycznie "zdemaskowały" agenta, który zastrzelił Good. AFP wcześniej zweryfikowała również zdjęcia wykorzystujące sztuczną inteligencję do "ulepszenia" nagrań z kamer bezpieczeństwa w celu zidentyfikowania sprawcy zabójstwa konserwatywnego aktywisty Charliego Kirka.

Więcej informacji na temat dezinformacji dotyczących protestów w Minneapolis można znaleźć tutaj, a na temat sztucznej inteligencji tutaj.

Copyright © AFP 2017-2026. Jakiekolwiek komercyjne wykorzystywanie powyższych treści wymaga subskrypcji serwisu. Więcej informacji znajdą Państwo pod tym linkiem.

Zastanawiasz się czy informacja jest prawdziwa? Napisz do nas. Sprawdzimy

Skontaktuj się z nami